- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

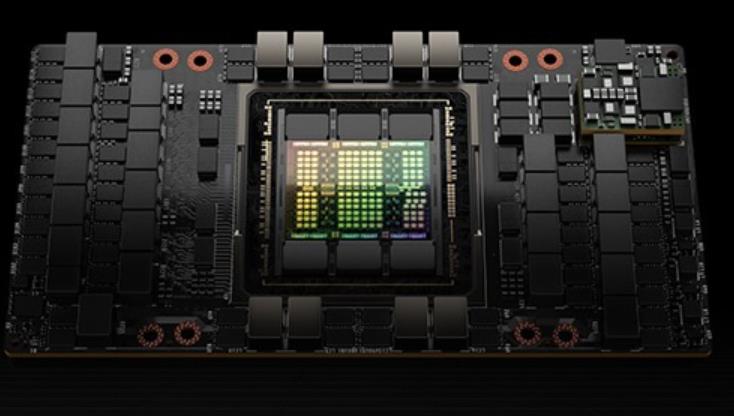

- 8 H100 80GB NVlink

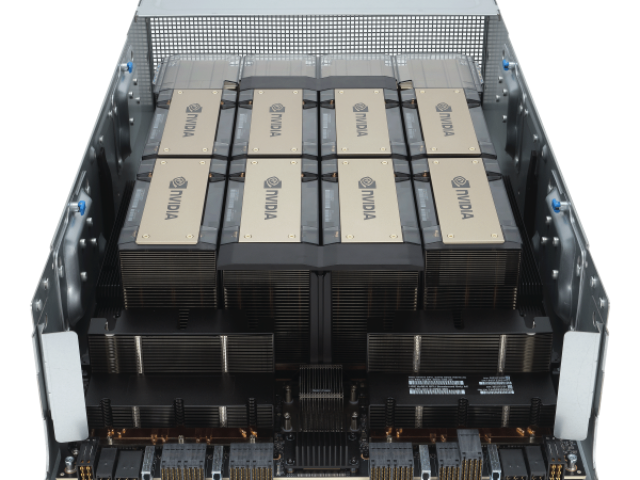

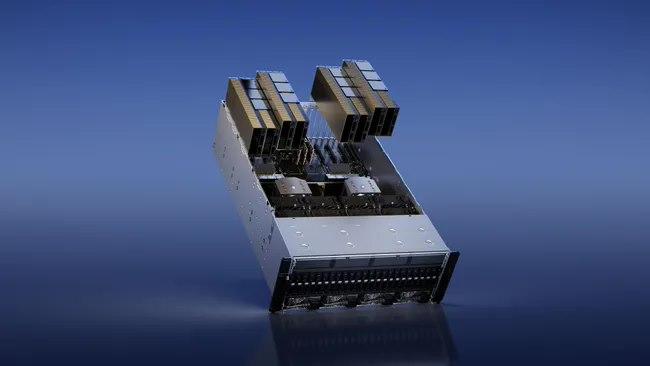

用于训练、推理和分析。配置了Bluefield-3,NDRInfiniBand和第二代MIG技术单个DGXH100系统提供了16petaFLOPS(千万亿次浮点运算)(FP16稀疏AI计算性能)。通过将多个DGXH100系统连接组成集群(称为DGXPODs或DGXSuperPODs),可以很容易地扩大这种性能。DGXSuperPOD从32个DGXH100系统开始,被称为"可扩展单元"集成了256个H100GPU,这些GPU通过基于第三代NVSwitch技术的新的二级NVLink交换机连接,提供了1exaFLOP的FP8稀疏AI计算性能。同时支持无线带宽(InifiniBand,IB)和NVLINKSwitch网络选项。HGXH100通过NVLink和NVSwitch提供的高速互连,HGXH100将多个H100结合起来,使其能创建世界上强大的可扩展服务器。HGXH100可作为服务器构建模块,以集成底板的形式在4个或8个H100GPU配置中使用。H100CNXConvergedAcceleratorNVIDIAH100CNX将NVIDIAH100GPU的强大功能与NVIDIA®ConnectX-7SmartNIC的**组网能力相结合,可提供高达400Gb/s的带宽包括NVIDIAASAP2(加速交换和分组处理)等创新功能,以及用于TLS/IPsec/MACsec加密/的在线硬件加速。这种独特的架构为GPU驱动的I/O密集型工作负载提供了前所未有的性能,如在企业数据中心进行分布式AI训练,或在边缘进行5G信号处理等。近期 H100 GPU 的价格波动引起了关注。xfusionH100GPU price

每个GPU实例在整个内存系统中都有单独的和孤立的路径--片上的交叉开关端口、L2缓存库、内存控制器和DRAM地址总线都是分配给单个实例的。这保证了单个用户的工作负载可以以可预测的吞吐量和延迟运行,具有相同的L2缓存分配和DRAM带宽,即使其他任务正在冲击自己的缓存或使其DRAM接口饱和。H100MIG改进:提供完全安全的、云原生的多租户、多用户的配置。Transformer引擎Transformer模型是当今从BERT到GPT-3使用的语言模型的支柱,需要巨大的计算资源。第四代NVLink和NVLink网络PCIe以其有限的带宽形成了一个瓶颈。为了构建强大的端到端计算平台,需要更快速、更可扩展的NVLink互连。NVLink是NVIDIA公司推出的高带宽、高能效、低延迟、无损的GPU-to-GPU互连。其中包括弹性特性,如链路级错误检测和数据包重放机制,以保证数据的成功传输。新的NVLink为多GPUIO和共享内存访问提供了900GB/s的总带宽,为PCIeGen5提供了7倍的带宽。A100GPU中的第三代NVLink在每个方向上使用4个差分对(4个通道)来创建单条链路,在每个方向上提供25GB/s的有效带宽,而第四代NVLink在每个方向上使用2个高速差分对来形成单条链路,在每个方向上也提供25GB/s的有效带宽。引入了新的NVLink网络互连。QatarH100GPUH100 GPU 提供高效的计算资源利用率。

他们与来自大云(Azure,GoogleCloud,AWS)的一些人交谈,试图获得许多H100。他们发现他们无法从大云中获得大量分配,并且一些大云没有良好的网络设置。因此,他们与其他提供商(如CoreWeave,Oracle,Lambda,FluidStack)进行了交谈。如果他们想自己购买GPU并拥有它们,也许他们也会与OEM和Nvidia交谈。终,他们获得了大量的GPU。现在,他们试图获得产品市场契合度。如果不是很明显,这条途径就没有那么好了-请记住,OpenAI在更小的模型上获得了产品市场契合度,然后将它们扩大了规模。但是,现在要获得产品市场契合度,您必须比OpenAI的模型更适合用户的用例,因此首先,您将需要比OpenAI开始时更多的GPU。预计至少到100年底,H2023将短缺数百或数千次部署。到2023年底,情况将更加清晰,但就目前而言,短缺似乎也可能持续到2024年的某些时间。GPU供需之旅。大版本取得联系#作者:克莱·帕斯卡。问题和笔记可以通过电子邮件发送。新帖子:通过电子邮件接收有关新帖子的通知。帮助:看这里。自然的下一个问题-英伟达替代品呢?#自然的下一个问题是“好吧,竞争和替代方案呢?我正在探索硬件替代方案以及软件方法。提交我应该探索的东西作为此表格的替代方案。例如。

在未来,我们将继续加强与 NVIDIA 的合作,推出更多基于 H100 GPU 的创新解决方案。ITMALL.sale 将不断拓展产品线,满足不同领域客户的需求,并提供更多增值服务,如技术咨询、培训、定制化解决方案等。ITMALL.sale 还将继续优化物流和售后服务体系,提高客户满意度。通过不断创新和提升,ITMALL.sale 致力于成为客户优先的 H100 GPU 供应商,为客户创造更大的价值。ITMALL.sale 的目标是通过持续的技术创新和服务提升,为客户提供更好的产品和服务体验,助力客户业务的成功和发展。H100 GPU 限时特惠,立刻下单。

它可能每年产生$500mm++的经常性收入。ChatGPT运行在GPT-4和API上。GPT-4和API需要GPU才能运行。很多。OpenAI希望为ChatGPT及其API发布更多功能,但他们不能,因为他们无法访问足够的GPU。他们通过Microsoft/Azure购买了很多NvidiaGPU。具体来说,他们想要的GPU是NvidiaH100GPU。为了制造H100SXMGPU,Nvidia使用台积电进行制造,并使用台积电的CoWoS封装技术,并使用主要来自SK海力士的HBM3。OpenAI并不是***一家想要GPU的公司(但他们是产品市场契合度强的公司)。其他公司也希望训练大型AI模型。其中一些用例是有意义的,但有些用例更多的是驱动的,不太可能使产品与市场契合。这推高了需求。此外,一些公司担心将来无法访问GPU,因此即使他们还不需要它们,他们现在也会下订单。因此,“对供应短缺的预期会造成更多的供应短缺”正在发生。GPU需求的另一个主要贡献者来自想要创建新的LLM的公司。以下是关于想要构建新LLM的公司对GPU需求的故事:公司高管或创始人知道人工智能领域有很大的机会。也许他们是一家想要在自己的数据上训练LLM并在外部使用它或出售访问权限的企业,或者他们是一家想要构建LLM并出售访问权限的初创公司。他们知道他们需要GPU来训练大型模型。H100 GPU 促销降价,快来选购。CPUH100GPU list price

H100 GPU 提供高效的视频编辑支持。xfusionH100GPU price

ITMALL.sale 拥有丰富的行业经验和专业的技术团队,能够为客户提供专业的 H100 GPU 咨询和技术支持。ITMALL.sale 深知每个客户的需求都是独特的,因此在销售过程中注重与客户的沟通,了解其具体需求,提供量身定制的解决方案。ITMALL.sale 的技术团队能够帮助客户快速部署和优化 H100 GPU 系统,确保其能够充分发挥 H100 GPU 的强大性能,为客户的业务发展提供强有力的支持。

ITMALL.sale 拥有完善的供应链和物流体系,确保客户能够快速、便捷地获得 H100 GPU 产品。ITMALL.sale 与多家物流公司合作,能够提供灵活的配送服务,满足不同客户的配送需求。无论是大批量采购还是小批量订购,ITMALL.sale 都能够确保产品及时送达。ITMALL.sale 的仓储和物流团队经过专业培训,能够高效、安全地处理每一笔订单,确保产品在运输过程中完好无损地送到客户手中。 xfusionH100GPU price

- Dubai英伟达H100GPU 2025-01-06

- 广东H100GPU货期 2025-01-03

- LenovoH100GPU总代 2025-01-02

- LenovoH100GPU how much 2024-12-30

- LenovoH100GPU discount 2024-12-27

- HBMH100GPU www.itmall.sale 2024-12-27

- DubaiH100GPU price 2024-12-26

- 英伟达H100GPU价格 2024-12-26

- AmericaH100GPU现货 2024-12-25

- 套装H100GPU list price 2024-12-24

- xfusionH100GPU how much 2024-12-24

- 上海订购H100GPU 2024-12-24