- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

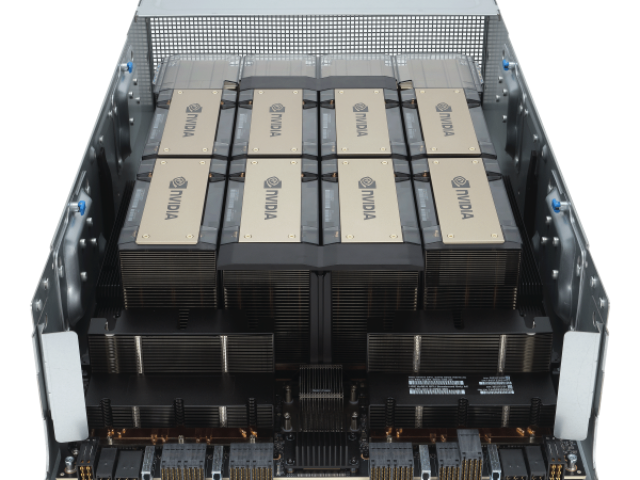

- 8 H100 80GB NVlink

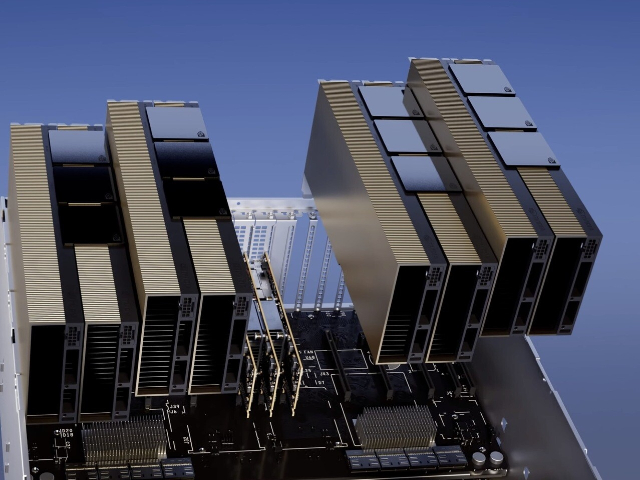

使用TSMC4nm工艺定制800亿个晶体管,814mm²芯片面积。NVIDIAGraceHopperSuperchipCPU+GPU架构NVIDIAGraceCPU:利用ARM架构的灵活性,创建了从底层设计的CPU和服务器架构,用于加速计算。H100:通过NVIDIA的超高速片间互连与Grace配对,能提供900GB/s的带宽,比PCIeGen5快了7倍目录H100GPU主要特征基于H100的系统和板卡H100张量架构FP8数据格式用于加速动态规划(“DynamicProgramming”)的DPX指令L1数据cache和共享内存结合H100GPU层次结构和异步性改进线程块集群(ThreadBlockClusters)分布式共享内存(DSMEM)异步执行H100HBM和L2cache内存架构H100HBM3和HBM2eDRAM子系统H100L2cache内存子系统RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink网络第三代NVSwitch新的NVLink交换系统PCIeGen5安全性增强和保密计算H100video/IO特征H100GPU主要特征新的流式多处理器(StreamingMultiprocessor,SM)第四代张量:片间通信速率提高了6倍(包括单个SM加速、额外的SM数量、更高的时钟);在等效数据类型上提供了2倍的矩阵乘加。MatrixMultiply-Accumulate,MMA)计算速率,相比于之前的16位浮点运算,使用新的FP8数据类型使速率提高了4倍。H100 GPU 支持 Tensor Core 技术。SupermicroH100GPU price

在大数据分析领域,H100 GPU 展现了其强大的数据处理能力。它能够快速处理和分析海量数据,提供实时的分析结果,帮助企业做出更快的决策。无论是在金融分析、市场预测还是用户行为分析中,H100 GPU 都能提升数据处理速度和分析准确性。其高能效设计不仅提升了性能,还为企业节省了大量的能源成本,成为大数据分析的理想硬件。H100 GPU 在云计算中的应用也非常多。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。湖南H100GPU促销价H100 GPU 降价特惠,先到先得。

节点内部的每个NVSwitch提供64个第四代NVLink链路端口,以加速多GPU连接。交换机的总吞吐率从上一代的。新的第三代NVSwitch技术也为多播和NVIDIASHARP网络内精简的集群操作提供了硬件加速。新的NVLinkSwitch系统互连技术和新的基于第三代NVSwitch技术的第二级NVLink交换机引入地址空间隔离和保护,使得多达32个节点或256个GPU可以通过NVLink以2:1的锥形胖树拓扑连接。这些相连的节点能够提供TB/sec的全连接带宽,并且能够提供难以置信的一个exaFlop(百亿亿次浮点运算)的FP8稀疏AI计算。PCIeGen5提供了128GB/sec的总带宽(各个方向上为64GB/s),而Gen4PCIe提供了64GB/sec的总带宽(各个方向上为32GB/sec)。PCIeGen5使H100可以与性能高的x86CPU和SmartNICs/DPU(数据处理单元)接口。基于H100的系统和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡内置H100GPU和HMB3内存堆栈提供第四代NVLink和PCIeGen5连接提供高的应用性能这种配置非常适合在一个服务器和跨服务器的情况下将应用程序扩展到多个GPU上的客户。通过在HGXH100服务器板卡上配置4-GPU和8-GPU实现4-GPU配置:包括GPU之间的点对点NVLink连接,并在服务器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch。

在人工智能应用中,H100 GPU 的计算能力尤为突出。它能够快速处理大量复杂的模型训练和推理任务,大幅缩短开发时间。H100 GPU 的并行计算能力和高带宽内存使其能够处理更大规模的数据集和更复杂的模型结构,提升了AI模型的训练效率和准确性。此外,H100 GPU 的高能效比和稳定性也为企业和研究机构节省了运营成本,是人工智能开发的理想选择。H100 GPU 的高带宽内存确保了数据传输的高效性,使得复杂任务得以顺利进行。其先进的架构设计不仅提升了计算性能,还优化了资源的使用效率,使得人工智能应用能够更快、更精细地实现技术突破。H100 GPU 优惠销售,机会难得。

H100 GPU 支持新的 PCIe 4.0 接口,提供了更高的数据传输速度和带宽,与前代 PCIe 3.0 相比,带宽提升了两倍。这使得 H100 GPU 在与主机系统通信时能够更快速地交换数据,减少了 I/O 瓶颈,进一步提升了整体系统性能。PCIe 4.0 的支持使得 H100 GPU 能够与现代主流服务器和工作站更好地兼容,充分发挥其高性能计算能力。H100 GPU 也采用了多项创新技术。其采用了先进的风冷和液冷混合散热设计,能够在高负载运行时保持稳定的温度,确保 GPU 的长期稳定运行H100 GPU 优惠促销,数量有限。订购H100GPU distributor

H100 GPU 支持 PCIe 4.0 接口。SupermicroH100GPU price

使用张量维度和块坐标来定义数据传输,而不是每个元素寻址。TMA操作是异步的,利用了基于共享内存的异步屏障。TMA编程模型是单线程的,选择一个经线程中的单个线程发出一个异步TMA操作(cuda::memcpy_async)来复制一个张量,随后多个线程可以在一个cuda::barrier上等待完成数据传输。H100SM增加了硬件来加速这些异步屏障等待操作。TMA的一个主要***是它可以使线程自由地执行其他的工作。在Hopper上,TMA包揽一切。单个线程在启动TMA之前创建一个副本描述符,从那时起地址生成和数据移动在硬件中处理。TMA提供了一个简单得多的编程模型,因为它在复制张量的片段时承担了计算步幅、偏移量和边界计算的任务。异步事务屏障(“AsynchronousTransactionBarrier”)异步屏障:-将同步过程分为两步。①线程在生成其共享数据的一部分时发出"到达"的信号。这个"到达"是非阻塞的。因此线程可以自由地执行其他的工作。②终线程需要其他所有线程产生的数据。在这一点上,他们做一个"等待",直到每个线程都有"抵达"的信号。-***是允许提前到达的线程在等待时执行的工作。-等待的线程会在共享内存中的屏障对象上自转(spin)。SupermicroH100GPU price

- 40GH100GPU多少钱一台 2024-10-30

- Qatar戴尔H100GPU 2024-10-30

- 超微H100GPU how much 2024-10-29

- TaiwanH100GPU discount 2024-10-29

- QatarH100GPU促销价 2024-10-29

- HPEH100GPU库存 2024-10-29

- xfusionH100GPU price 2024-10-29

- H100GPU总代 2024-10-29

- SupermicroH100GPU优惠 2024-10-29

- 香港H100GPU一台多少钱 2024-10-29

- NvdiaH100GPU 2024-10-28

- SupermicroH100GPU促销 2024-10-28