- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

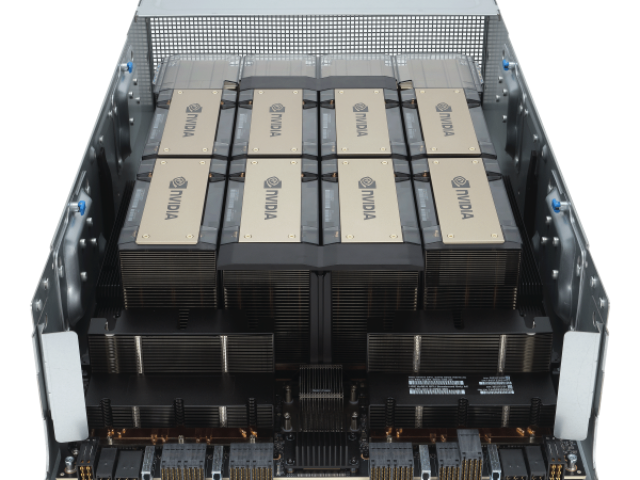

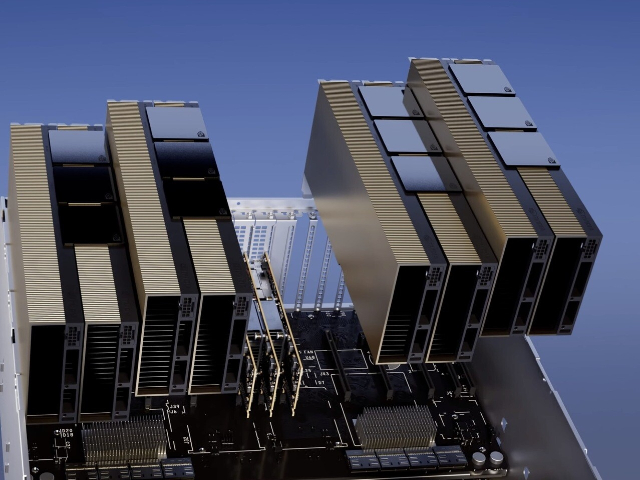

- 8 H100 80GB NVlink

增加了一个称为线程块集群(ThreadBlockCluster)的新模块,集群(Cluster)是一组线程块(ThreadBlock),保证线程可以被并发调度,从而实现跨多个SM的线程之间的**协作和数据共享。集群还能更有效地协同驱动异步单元,如张量内存***(TensorMemoryAccelerator)和张量NVIDIA的异步事务屏障(“AsynchronousTransactionBarrier”)使集群中的通用CUDA线程和片上***能够有效地同步,即使它们驻留在单独的SM上。所有这些新特性使得每个用户和应用程序都可以在任何时候充分利用它们的H100GPU的所有单元,使得H100成为迄今为止功能强大、可编程性强、能效高的GPU。组成多个GPU处理集群(GPUProcessingClusters,GPCs)TextureProcessingClusters(TPCs)流式多处理器(StreamingMultiprocessors,SM)L2CacheHBM3内存控制器GH100GPU的完整实现8GPUs9TPCs/GPU(共72TPCs)2SMs/TPC(共144SMs)128FP32CUDA/SM4个第四代张量/SM6HBM3/HBM2e堆栈。12个512位内存控制器60MBL2Cache第四代NVLink和PCIeGen5H100SM架构引入FP8新的Transformer引擎新的DPX指令H100张量架构专门用于矩阵乘和累加(MMA)数学运算的高性能计算,为AI和HPC应用提供了开创性的性能。。对于开发者来说,H100 GPU 的稳定性和高能效为长时间的开发和测试提供了可靠保障.上海NVLINKH100GPU

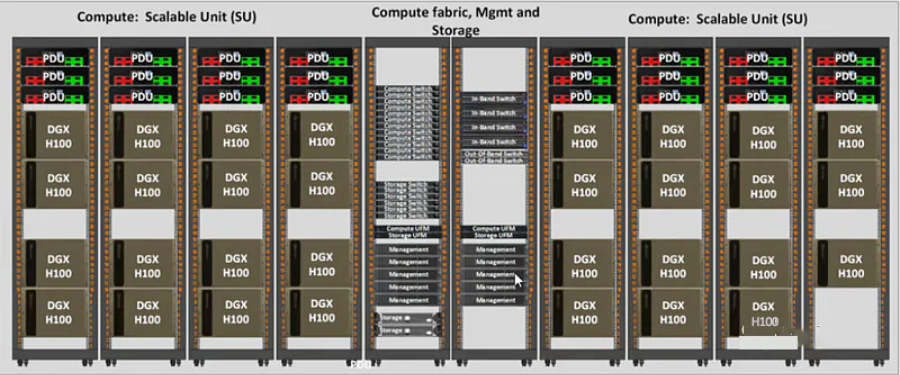

他们与英伟达合作托管了一个基于NVIDIA的集群。Nvidia也是Azure的客户。哪个大云拥有好的网络?#Azure,CoreWeave和Lambda都使用InfiniBand。Oracle具有良好的网络,它是3200Gbps,但它是以太网而不是InfiniBand,对于高参数计数LLM训练等用例,InfiniBand可能比IB慢15-20%左右。AWS和GCP的网络就没有那么好了。企业使用哪些大云?#在一个大约15家企业的私有数据点中,所有15家都是AWS,GCP或Azure,零甲骨文。大多数企业将坚持使用现有的云。绝望的初创公司会去哪里,哪里就有供应。DGXCloud怎么样,英伟达正在与谁合作?#“NVIDIA正在与的云服务提供商合作托管DGX云基础设施,从Oracle云基础设施(OCI)开始”-您处理Nvidia的销售,但您通过现有的云提供商租用它(首先使用Oracle启动,然后是Azure,然后是GoogleCloud,而不是使用AWS启动)3233Jensen在上一次财报电话会议上表示:“理想的组合是10%的NvidiaDGX云和90%的CSP云。大云什么时候推出他们的H100预览?#CoreWeave是个。34英伟达给了他们较早的分配,大概是为了帮助加强大型云之间的竞争(因为英伟达是投资者)。Azure于13月100日宣布H<>可供预览。35甲骨文于21月100日宣布H<>数量有限。Singapore模组H100GPUH100 GPU 适用于人工智能训练任务。

英伟达可以纯粹提高价格以找到清算价格,并且在某种程度上正在这样做。但重要的是要知道,终H100的分配取决于Nvidia更喜欢将分配分配给谁。供应H100显卡#造成瓶颈的原因-供应生产方面的瓶颈是什么?哪些组件?谁生产它们?谁制造了H100?#台积电。英伟达可以使用其他芯片厂进行H100生产吗?#不是真的,至少现在还没有。他们过去曾与三星合作过。但在H100和其他5nmGPU上,他们只使用台积电。这意味着三星还不能满足他们对前列GPU的需求。他们将来可能会与英特尔合作,并再次与三星合作,但这些都不会在短期内以有助于H100供应紧缩的方式发生。不同的台积电节点如何关联?#台积电5nm系列:N5264N要么适合作为N5的增强版本,要么低于N5PN5P4N要么适合作为N5P的增强版本,要么低于N5作为N5的增强版本N4N4PH100是在哪个台积电节点上制造的?#台积电4N。这是Nvidia的一个特殊节点,它属于5nm系列,并且是增强的5nm,而不是真正的4nm。还有谁使用该节点?#是苹果,但他们主要转向N3,并保留了大部分N3容量。高通和AMD是N5家族的其他大客户。A100使用哪个台积电节点?#N727晶圆厂产能通常提前多久预留?#不确定,虽然可能是12+个月。

硬件方面的TPU,Inferentia,LLMASIC和其他产品,以及软件方面的Mojo,Triton和其他产品,以及使用AMD硬件和软件的样子。我正在探索一切,尽管专注于***可用的东西。如果您是自由职业者,并希望帮助Llama2在不同的硬件上运行,请给我发电子邮件。到目前为止,我们已经在AMD,Gaudi上运行了TPU和Inferentia,并且来自AWSSilicon,R**n,Groq,Cerebras和其他公司的人员提供了帮助。确认#本文包含大量专有和以前未发布的信息。当您看到人们对GPU生产能力感到疑惑时,请向他们指出这篇文章的方向。感谢私有GPU云公司的少数高管和创始人,一些AI创始人,ML工程师,深度学习研究员,其他一些行业和一些非行业读者,他们提供了有用的评论。感谢哈米德的插图。A100\H100基本上越来越少,A800目前也在位H800让路,如果确实需要A100\A800\H100\H800GPU,建议就不用挑剔了,HGX和PCIE版对大部分使用者来说区别不是很大,有货就可以下手了。无论如何,选择正规品牌厂商合作,在目前供需失衡不正常的市场情况下,市面大部分商家是无法供应的,甚至提供不属实的信息。H100 GPU 支持 Tensor Core 技术。

在游戏开发领域,H100 GPU 提供了强大的图形处理能力和计算性能。它能够实现复杂和逼真的游戏画面,提高游戏的视觉效果和玩家体验。H100 GPU 的并行处理单元可以高效处理大量图形和物理运算,减少延迟和卡顿现象。对于开发者来说,H100 GPU 的稳定性和高能效为长时间的开发和测试提供了可靠保障,助力开发者创造出更具创意和吸引力的游戏作品,是游戏开发的理想选择。其高带宽内存确保了复杂任务的顺利进行。H100 GPU 的强大图形处理能力不仅提升了游戏的视觉效果,还使得游戏运行更加流畅,玩家体验更加出色,推动了游戏开发技术的不断进步。H100 GPU 降价促销,机会难得。广东H100GPU优惠

H100 GPU 适用于虚拟现实开发。上海NVLINKH100GPU

使用张量维度和块坐标来定义数据传输,而不是每个元素寻址。TMA操作是异步的,利用了基于共享内存的异步屏障。TMA编程模型是单线程的,选择一个经线程中的单个线程发出一个异步TMA操作(cuda::memcpy_async)来复制一个张量,随后多个线程可以在一个cuda::barrier上等待完成数据传输。H100SM增加了硬件来加速这些异步屏障等待操作。TMA的一个主要***是它可以使线程自由地执行其他的工作。在Hopper上,TMA包揽一切。单个线程在启动TMA之前创建一个副本描述符,从那时起地址生成和数据移动在硬件中处理。TMA提供了一个简单得多的编程模型,因为它在复制张量的片段时承担了计算步幅、偏移量和边界计算的任务。异步事务屏障(“AsynchronousTransactionBarrier”)异步屏障:-将同步过程分为两步。①线程在生成其共享数据的一部分时发出"到达"的信号。这个"到达"是非阻塞的。因此线程可以自由地执行其他的工作。②终线程需要其他所有线程产生的数据。在这一点上,他们做一个"等待",直到每个线程都有"抵达"的信号。-***是允许提前到达的线程在等待时执行的工作。-等待的线程会在共享内存中的屏障对象上自转(spin)。上海NVLINKH100GPU

- 40GH100GPU多少钱一台 2024-10-30

- Qatar戴尔H100GPU 2024-10-30

- 超微H100GPU how much 2024-10-29

- TaiwanH100GPU discount 2024-10-29

- QatarH100GPU促销价 2024-10-29

- HPEH100GPU库存 2024-10-29

- xfusionH100GPU price 2024-10-29

- H100GPU总代 2024-10-29

- SupermicroH100GPU优惠 2024-10-29

- 香港H100GPU一台多少钱 2024-10-29

- NvdiaH100GPU 2024-10-28

- SupermicroH100GPU促销 2024-10-28