- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

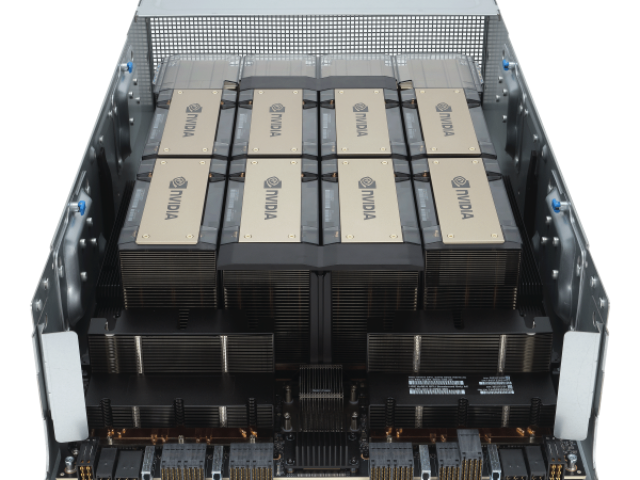

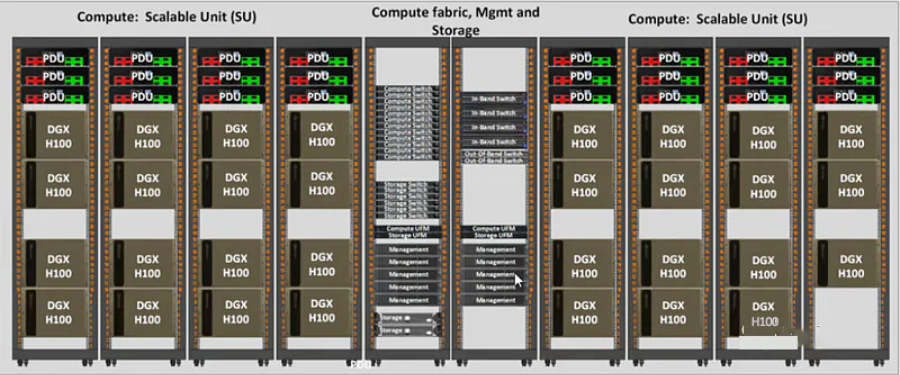

- 8 H100 80GB NVlink

H100 GPU 在云计算中的应用也非常多。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。其高能效设计不仅提升了性能,还为企业节省了大量的能源成本。通过在云计算平台中的应用,H100 GPU 不仅提高了计算资源的利用率,还实现了资源的灵活调配和高效管理,为企业和个人用户提供了更加便捷和高效的计算服务。H100 GPU 提供高效的 GPU 直连技术。HPEH100GPU总代

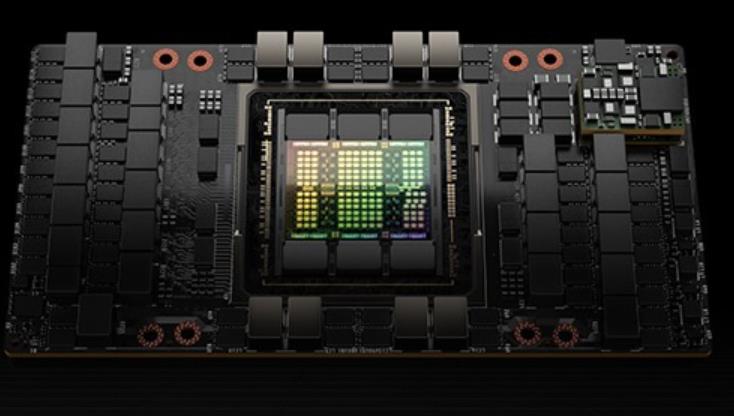

使用TSMC4nm工艺定制800亿个晶体管,814mm²芯片面积。NVIDIAGraceHopperSuperchipCPU+GPU架构NVIDIAGraceCPU:利用ARM架构的灵活性,创建了从底层设计的CPU和服务器架构,用于加速计算。H100:通过NVIDIA的超高速片间互连与Grace配对,能提供900GB/s的带宽,比PCIeGen5快了7倍目录H100GPU主要特征基于H100的系统和板卡H100张量架构FP8数据格式用于加速动态规划(“DynamicProgramming”)的DPX指令L1数据cache和共享内存结合H100GPU层次结构和异步性改进线程块集群(ThreadBlockClusters)分布式共享内存(DSMEM)异步执行H100HBM和L2cache内存架构H100HBM3和HBM2eDRAM子系统H100L2cache内存子系统RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink网络第三代NVSwitch新的NVLink交换系统PCIeGen5安全性增强和保密计算H100video/IO特征H100GPU主要特征新的流式多处理器(StreamingMultiprocessor,SM)第四代张量:片间通信速率提高了6倍(包括单个SM加速、额外的SM数量、更高的时钟);在等效数据类型上提供了2倍的矩阵乘加。MatrixMultiply-Accumulate,MMA)计算速率,相比于之前的16位浮点运算,使用新的FP8数据类型使速率提高了4倍。NvdiaH100GPU购买H100 GPU 提供 312 TFLOPS 的 Tensor Core 性能。

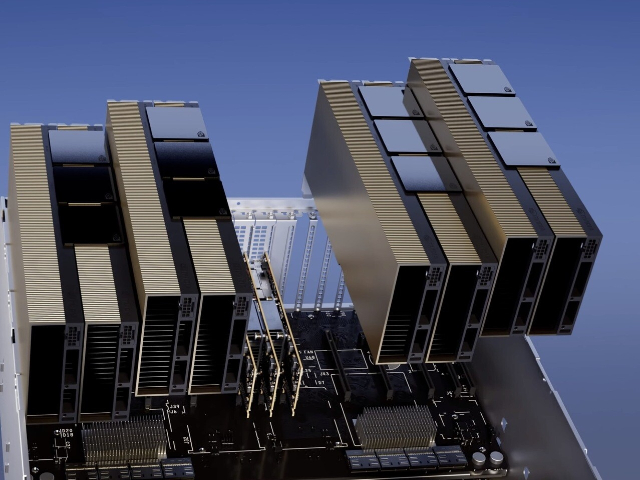

H100 GPU 是英伟达推出的一款高性能图形处理器,旨在满足当今数据密集型计算任务的需求。它采用新的架构,具备强大的计算能力和能效比,能够提升各种计算任务的效率和速度。无论是在人工智能、科学计算还是大数据分析领域,H100 GPU 都能提供良好的性能和可靠性。其并行处理能力和高带宽内存确保了复杂任务的顺利进行,是各类高性能计算应用的良好选择。H100 GPU 拥有先进的散热设计,确保其在长时间高负荷运行时依然能够保持稳定和高效。对于需要长时间运行的大规模计算任务来说,H100 GPU 的可靠性和稳定性尤为重要。它的设计不仅考虑了性能,还兼顾了散热和能效,使其在保持高性能的同时,依然能够节省能源成本。无论是企业级应用还是科学研究,H100 GPU 都能够为用户提供持续的高性能支持。

H100 GPU 在云计算平台中的应用也非常多。其高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。H100 GPU 在云计算中的应用也非常多。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。H100 GPU 采用先进的风冷和液冷混合散热设计。

L2CacheHBM3内存控制器GH100GPU的完整实现8GPUs9TPCs/GPU(共72TPCs)2SMs/TPC(共144SMs)128FP32CUDA/SM4个第四代张量/SM6HBM3/HBM2e堆栈,12个512位内存控制器60MBL2Cache第四代NVLink和PCIeGen5H100SM架构引入FP8新的Transformer引擎新的DPX指令H100张量架构专门用于矩阵乘和累加(MMA)数学运算的高性能计算,为AI和HPC应用提供了开创性的性能。H100中新的第四代TensorCore架构提供了每SM的原始稠密和稀疏矩阵数学吞吐量的两倍支持FP8、FP16、BF16、TF32、FP64、INT8等MMA数据类型。新的TensorCores还具有更**的数据管理,节省了高达30%的操作数交付能力。FP8数据格式与FP16相比,FP8的数据存储需求减半,吞吐量提高一倍。新的TransformerEngine(在下面的章节中进行阐述)同时使用FP8和FP16两种精度,以减少内存占用和提高性能,同时对大型语言和其他模型仍然保持精度。用于加速动态规划(“DynamicProgramming”)的DPX指令新引入的DPX指令为许多DP算法的内循环提供了高等融合操作数的支持,使得动态规划算法的性能相比于AmpereGPU高提升了7倍。L1数据cache和共享内存结合将L1数据cache和共享内存功能合并到单个内存块中简化了编程。H100 GPU 降价特惠,先到先得。套装H100GPU总代

H100 GPU 降价特惠,赶快抢购。HPEH100GPU总代

他们与来自大云(Azure,GoogleCloud,AWS)的一些人交谈,试图获得许多H100。他们发现他们无法从大云中获得大量分配,并且一些大云没有良好的网络设置。因此,他们与其他提供商(如CoreWeave,Oracle,Lambda,FluidStack)进行了交谈。如果他们想自己购买GPU并拥有它们,也许他们也会与OEM和Nvidia交谈。终,他们获得了大量的GPU。现在,他们试图获得产品市场契合度。如果不是很明显,这条途径就没有那么好了-请记住,OpenAI在更小的模型上获得了产品市场契合度,然后将它们扩大了规模。但是,现在要获得产品市场契合度,您必须比OpenAI的模型更适合用户的用例,因此首先,您将需要比OpenAI开始时更多的GPU。预计至少到100年底,H2023将短缺数百或数千次部署。到2023年底,情况将更加清晰,但就目前而言,短缺似乎也可能持续到2024年的某些时间。GPU供需之旅。大版本取得联系#作者:克莱·帕斯卡。问题和笔记可以通过电子邮件发送。新帖子:通过电子邮件接收有关新帖子的通知。帮助:看这里。自然的下一个问题-英伟达替代品呢?#自然的下一个问题是“好吧,竞争和替代方案呢?我正在探索硬件替代方案以及软件方法。提交我应该探索的东西作为此表格的替代方案。例如。HPEH100GPU总代

- 40GH100GPU多少钱一台 2024-10-30

- Qatar戴尔H100GPU 2024-10-30

- 超微H100GPU how much 2024-10-29

- TaiwanH100GPU discount 2024-10-29

- QatarH100GPU促销价 2024-10-29

- HPEH100GPU库存 2024-10-29

- xfusionH100GPU price 2024-10-29

- H100GPU总代 2024-10-29

- SupermicroH100GPU优惠 2024-10-29

- 香港H100GPU一台多少钱 2024-10-29

- NvdiaH100GPU 2024-10-28

- SupermicroH100GPU促销 2024-10-28